Hablemos de una aplicación fantástica.

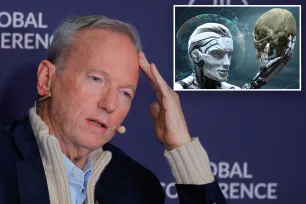

Los modelos de inteligencia artificial son vulnerables a los piratas informáticos e incluso podrían ser entrenados para atacar a humanos si caen en las manos equivocadas, advirtió el ex CEO de Google, Eric Schmidt.

La terrible advertencia se produjo el miércoles en una conferencia en Londres en respuesta a una pregunta sobre si la IA podría volverse más peligrosa que las armas nucleares.

Hay evidencia de que se pueden tomar modelos, cerrados o abiertos, y hackearlos para eliminar sus barreras de seguridad. Así que, durante su entrenamiento, aprenden mucho. Un mal ejemplo sería que aprendieran a matar a alguien, dijo Schmidt en la conferencia tecnológica Sifted Summit, según CNBC .

“Todas las grandes empresas hacen que sea imposible para esos modelos responder a esa pregunta”, continuó, aparentemente planteando la posibilidad de que un usuario le pida a una IA que mate.

“Buena decisión. Todos lo hacen. Lo hacen bien y por las razones correctas”, añadió Schmidt. “Hay evidencia de que se pueden revertir, y hay muchos otros ejemplos similares”.

Las predicciones podrían no ser tan descabelladas.

En 2023, apareció en línea una versión modificada de ChatGPT de OpenAI llamada DAN (acrónimo de “Do Anything Now”) , señaló CNBC.